El siglo XXI ha sido testigo de la IA (Inteligencia Artificial) realizando tareas como derrotar fácilmente a los humanos en el ajedrez o enseñarles idiomas extranjeros rápidamente..

Una tarea más avanzada para la computadora sería predecir la probabilidad de que un delincuente cometa otro delito. Ese es el trabajo de un sistema de inteligencia artificial llamado COMPAS (Perfiles de gestión de delincuentes correccionales para sanciones alternativas). Pero resulta que esa herramienta no es mejor que un tipo promedio y también puede ser racista. Bueno, eso es exactamente lo que ha descubierto un equipo de investigación después de estudiar exhaustivamente el sistema de inteligencia artificial, que es ampliamente utilizado por las instituciones judiciales..

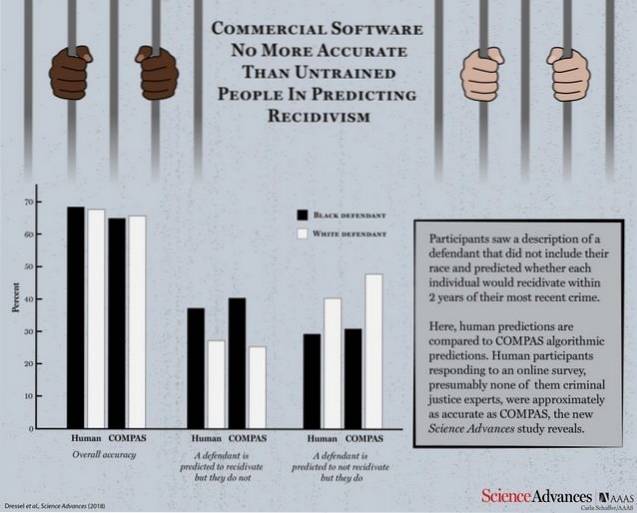

Según un artículo de investigación publicado por Science Advances, COMPAS se enfrentó a un grupo de participantes humanos para probar su eficiencia y comprobar qué tan bien le va contra las predicciones lógicas hechas por una persona normal. La máquina y los participantes humanos recibieron 1000 descripciones de prueba que contenían la edad, los delitos anteriores, el género, etc. de los delincuentes cuya probabilidad de reincidencia debía predecirse..

Con considerablemente menos información que COMPAS (solo 7 características en comparación con las 137 de COMPAS), una pequeña multitud de no expertos es tan precisa como COMPAS para predecir la reincidencia..

COMPAS registró una precisión general del 65,4% en la predicción de la reincidencia (la tendencia de un criminal condenado a reincidir), que es menor que la precisión de la predicción colectiva de los participantes humanos con un 67%.

Ahora, tómese un momento y reflexione en su mente que el sistema de inteligencia artificial, al que no le va mejor que a una persona promedio, fue utilizado por los tribunales para predecir la reincidencia..

El software comercial que se usa ampliamente para predecir la reincidencia no es más preciso o justo que las predicciones de personas con poca o ninguna experiencia en justicia penal que respondieron a una encuesta en línea..

Lo que es aún peor es el hecho de que se descubrió que el sistema era tan susceptible a los prejuicios raciales como sus homólogos humanos cuando se les pidió que pronosticaran la probabilidad de reincidencia a partir de descripciones que también contenían información racial de los delincuentes. No debería sorprenderse demasiado, ya que se sabe que la IA adopta los patrones que sus maestros humanos la programarán para aprender..

Aunque ambos lados no alcanzan drásticamente un puntaje de precisión aceptable, el punto de usar una herramienta de inteligencia artificial que no sea mejor que un ser humano promedio plantea muchas preguntas.

Gadgetshowto

Gadgetshowto