Google Maps es obviamente la aplicación de navegación y mapas más popular, no solo en Android sino también en iOS. Es la aplicación de referencia para obtener direcciones y buscar surtidores de gasolina, restaurantes u hospitales cercanos. Sin embargo, un usuario de Twitter se ha topado con una consulta de búsqueda despectiva que cuestiona el algoritmo de búsqueda de Google, especialmente porque deja a los niños pequeños vulnerables..

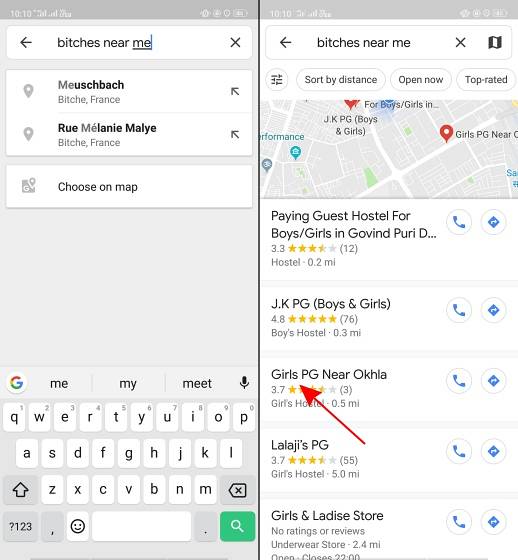

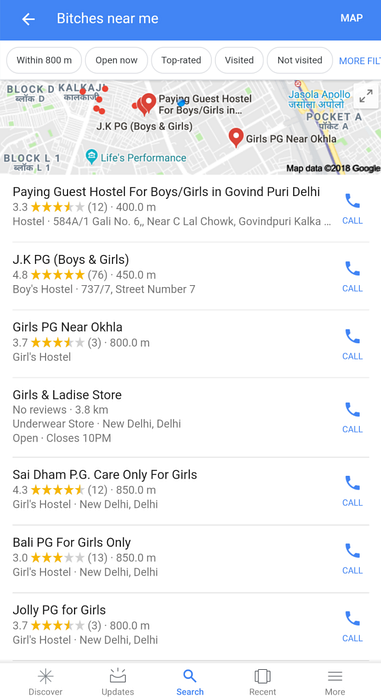

Según lo informado por el usuario de Twitter @AHappyChipmunk, si abres Google Maps y buscas "perras cerca de mí", el resultado de la búsqueda es espantoso. La plataforma recoge esta jerga despectiva (que condenamos) y muestra escuelas para niñas, universidades, albergues y apartamentos de pago para invitados, lo que hace que te detengas por un segundo. En un país como la India, donde sectores ignorantes de la población utilizan la palabra N despectiva para presumir, no es difícil imaginar términos de búsqueda como perras..

Google, ¿puedes explicar por qué existe este puto? Pic.twitter.com/w0eslFoVSz

- 🌻compañero avalakki ✨ (@Woolfingitdown) 25 de noviembre de 2018

Este tweet es una sorpresa terrible, pero ver el logo de una cuenta de Twitter troll (@trollenku) me hizo escéptico del tweet anterior, e inicialmente pensé que era una broma. Solo al usar la misma consulta de búsqueda nos dimos cuenta de que no se trata solo de escuelas: el algoritmo de Google devuelve todos los lugares cercanos que están relacionados con las niñas, incluidos los alquileres solo para niñas y otros albergues..

Lo mismo ocurre con las búsquedas de Google para esa frase:

Es necesario comprender que nadie en Google es responsable de esto. El algoritmo de Google parece estar correlacionando a las perras con las niñas, lo que vuelve a cuestionar el sesgo de la IA. Después de todo, una máquina solo aprenderá lo que le enseñes..

La el resultado de la búsqueda muestra el lado oscuro de la IA y cómo la cultura pop puede condicionarte a asociar ciertos términos con un género en particular. También destaca cómo piensan las personas que crean estos algoritmos de búsqueda. Google debería ser particularmente cauteloso después de la huelga masiva de empleados relacionada con el acoso sexual en sus oficinas a principios de este mes. La supuesta 'cultura de hermanos' en Google también le ha valido una o dos demandas. Y este último error de IA llega en un momento en que la visibilidad se amplifica gracias al movimiento #MeToo en India..

Mucha gente ha tuiteado a Google para obtener más información sobre este error del algoritmo. Le brindaremos la actualización una vez que obtengamos una respuesta de la empresa.

Gadgetshowto

Gadgetshowto

![La inspiración de Steve Jobs detrás del iPod [anécdota]](https://gadgetshowto.com/storage/img/images/steve-jobs-inspiration-behind-ipod-[anecdote].jpg)