Nuestra experiencia de primera mano con la tecnología de reconocimiento de imágenes de IA, Google Lens, ha demostrado que el aprendizaje automático seguramente ha recorrido un largo camino. Pero esta tecnología está lejos de ser perfecta y no es tan inteligente como esperábamos, principalmente porque el ritmo al que estamos entrenando a las computadoras para identificar modelos es lento. Además, algunas IA requieren cálculos avanzados para la red neuronal, y ciertamente no es la tarea más fácil de enseñar a una máquina..

Teniendo esto en cuenta, un grupo de investigadores de Google se encargó de poner a prueba los sistemas de reconocimiento de imágenes de IA y ver si pueden ser engañados o no..

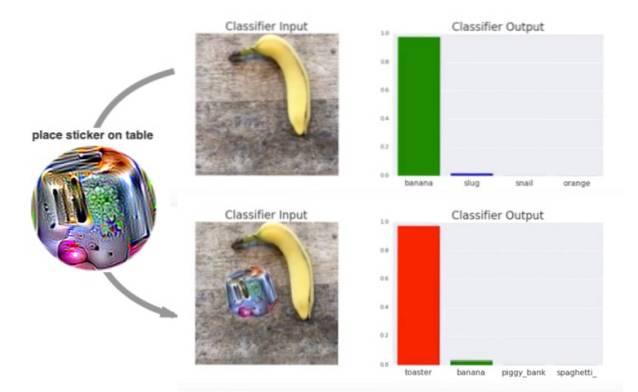

Parece que han salido victoriosos desde el El sistema de inteligencia artificial no pudo reconocer el objeto (aquí, un plátano) en las imágenes de muestra, todo gracias a una pegatina psicodélica especialmente impresa.

La creación de estos pegatinas psicodélicas que pueden engañar a los sistemas de reconocimiento de imágenes como se describe en un artículo de investigación titulado Adversarial Patch, que se acaba de presentar en la 31a conferencia sobre sistemas de procesamiento de información neuronal en diciembre de 2017. El documento explica que los investigadores entrenaron a un sistema adversario (oponente) para crear pequeños círculos psicodélicos en forma de parche con formas, colores y tamaños aleatorios para engañar al reconocimiento de imágenes sistema.

Si bien el método más común para engañar a los sistemas de reconocimiento de imágenes de IA es alterar una imagen agregando gráficos, los investigadores de Google decidieron engañar al sistema con diseños psicodélicos..

Como se ve en la demostración de video a continuación, el sistema es capaz de reconocer el plátano y, hasta cierto punto, la tostadora cuando coloca una imagen normal al lado del plátano. Pero los resultados son menos claros cuando se coloca un remolino psicodélico junto al plátano:

El equipo también descubrió que un El diseño parcheado parece separado del sujeto y no se ve afectado por factores. tales como condiciones de iluminación, ángulos de cámara, objetos en la vista del clasificador y el clasificador mismo.

Los investigadores continúan explicando el funcionamiento de los diseños psicodélicos:

Este ataque genera un parche independiente de la imagen que es extremadamente importante para una red neuronal. Este parche se puede colocar en cualquier lugar dentro del campo de visión del clasificador y hace que el clasificador genere una clase de destino..

Si bien a primera vista esto parece que el reconocimiento de imágenes de la IA está engañado, este experimento en realidad se utilizará para eliminar las inconsistencias en el sistema. Quienes trabajan en este campo ahora deben adaptarse a los datos ruidosos que se pueden incluir en las imágenes del sujeto. Este hallazgo podría dar a los sistemas impulsados por el aprendizaje automático la oportunidad de mejorarse a sí mismos frente a un engaño similar en el futuro.

Gadgetshowto

Gadgetshowto

![Algunos comentarios divertidos de la página de Facebook de Shraddha Sharma [Divertido]](https://gadgetshowto.com/storage/img/images/some-hilarious-comments-from-shraddha-sharmas-facebook-page-[funny]_16.JPG)